经历了去年基础模型底座的“百模大战”,今年大模型行业应用“百花齐放”,在众多关于AI的公众讨论中,如何推动场景应用是最热门的话题。

作为数据、资金高度集中的行业,金融业一直是是新兴技术落地的首选,在大模型时代更是如此。以科大讯飞为例,去年10月该公司推出了基于星火大模型底座的12个行业大模型,金融行业大模型居于首位,今年10月星火大模型升级到4.0 Turbo,七大核心能力全面超过GPT-4 Turbo,金融场景下的应用能力也进一步提升。

近期,21世纪经济报道《2024对话数字金融30人》栏目专访了科大讯飞金融科技事业部副总经理姚佶超,在他看来,近年来科技厂商不断提升通用大模型底座的能力,但厂商间技术迭代分化。

姚佶超指出,头部金融机构也在持续加大生成式AI的场景化应用,在远程银行、智能客服、智能营销、报告生成等方面实现应用落地。然而,大模型高昂的部署成本与算力支出让中小机构望而却步。

在整体降本增效的大背景下,姚佶超认为,金融行业的大模型应用需要平衡好投入和产出,应当基于场景需求出发选择不同参数规模的模型。

“从2022年11月OpenAI发布ChatGPT以来,我们统计过2023年中国发布了超过200个大模型,可以说是‘百模大战’,但今年明显感觉到行业在发生变化。”

在姚佶超看来,2024年作为大模型的应用元年,主要发生了两个变化。

第一是金融机构层面对大模型的理解和认知在逐步加深。一方面,机构更关注模型本身的技术迭代和技术进步;另一方面,机构开始聚焦场景化应用与实际产生的应用价值成效。

第二是科技公司层面,一些小公司“卷不动了”。“今年科技公司发布模型本身的技术迭代节奏和声量都相对去年少了很多,而且模型底座的进展主要集中在头部的科技公司。”姚佶超指出,这是2023年的“百模大战”后的必然发展趋势。“大部分科技公司发布的大模型都是基于海外开源大模型的二次精调、二次预训练,只有少数像科大讯飞一类的企业是从源头上自主创新研发大模型技术。而且大部分发布大模型的科技公司都只公开了底座和相关API,经过了一年的市场反应,能够在企业级应用上产生价值的很少。”

据姚佶超判断,未来两到三年内通过真正掌握大模型源头技术,实现模型底座持续迭代的科技型企业不会超过10个,其余公司的主要精力将集中于应用层面的研发工作。

在今年的大模型市场中,“价格战”是制约小型科技公司研发通用大模型的另一个因素。姚佶超认为,未来基于开源模型提供API服务的小型公司在行业降价与硬件算力成本提高的双重挤压下,可能会退出这一市场。而更多的公司会成为头部科技型企业的代理商,或者放弃大模型底座的平台化能力建设,转型做SAAS化应用服务,将智能化服务能力嵌入头部科技公司的大模型平台。

毋庸置疑,金融是最适合大模型落地应用的行业之一,但出于监管合规、数据安全、核心业务系统高度稳定等要求,行业仍在探索中前行,寻找最优的投入产出比。

科大讯飞经过一年的实践探索,姚佶超告诉记者,目前金融行业的大模型应用还存在三个方面的挑战。

首先,金融行业存在强监管要求、对客安全的刚性要求,而大模型本身存在的幻觉问题使得机构“不敢用”。为解决这一矛盾,技术厂商与金融机构从去年就开始探索如何解决模型安全问题。姚佶超指出,模型训练之初的源头数据和算法的自主创新,是最首要的安全保障。同时,厂商和机构都需要建立大模型安全保障机制,来过滤出内容层面的敏感信息与不安全信息,避免问题数据对模型产生污染。在金融场景下的实际应用层面,目前主流的解法是外挂知识库或以知识库协同的形式,保障特定场景下大模型生成内容的准确、稳定、安全、合规。

第二个挑战来自于大模型部署的高昂成本。姚佶超提到,出于数据安全的考量,金融机构的大模型应用一般是做私有化部署,而算力是大模型投入中金额占比最大的部分,且模型调优、专有模型训练都需要大量算力。据记者了解,大部分国产算力平台实际的推理效率和训练效率,只能达到英伟达平台30%-40%水平,而即使对英伟达来说,同一开源大模型在新一代NVIDIA GB200服务器系统的AI推理性能对比H200都提高了1.5倍。

在这样的背景下,姚佶超指出,大模型要源源不断产生价值,国产算力平台的训练效率和推理效率是关键。他告诉记者,在国产化算力平台上,讯飞经过一年与华为的紧密合作与共同探索,对大模型技术在国产算力平台上的推理和训练加速做了深度的优化,现在讯飞星火大模型可以在华为910B的NPU上实现推理、训练效率对齐英伟达A100的水平。

第三个挑战是金融机构在不同场景下选择部署怎样的模型存在困难。“在实际业务落地时,不是所有场景都需要千亿、万亿参数规模的大模型,在一些场景下其实百亿参数规模的模型就能产生很好的效果了。”在姚佶超看来,根据不同场景需要,金融机构应当选择性价比最高的模型,而这需要科技厂商有丰富的场景化落地经验,来设计对应的落地方案,帮助金融机构在不同场景下实现较好的应用效果与合理的投入产出比。

要快速看到业务应用的价值,姚佶超认为,金融行业大模型落地的关键是结合需求和技术可行性,选择成熟的应用场景。他指出,目前在文档知识问答、客服交互、坐席助手、报告写作、营销展业等场景上,金融机构有着强烈的提质增效需求,大模型在这些场景的应用也已经取得一定的价值成效。

在金融机构持续加大AI投入的同时,金融服务的智能化水平也随之提升,智能客服作为金融行业最早应用AI技术的场景,是C端客户体验最深的应用。

21世纪资管研究院曾对13家头部商业银行App的智能客服体验进行测评,人机结合带来的用户交互体验已显著升级,但部分银行智能客服依然存在同质化问题。对此,姚佶超向记者表示,基于传统AI的智能客服经过6-7年的技术迭代,金融机构智能客服的应用水平已逐步拉齐,但大模型技术将深刻改变未来智能客服的体验。

姚佶超指出,从讯飞星火大模型的实践来看,大模型对智能客服的改进将集中在四个层面。首先是模型底层技术的迭代,包括认知技术、语音技术以及统一建模等技术迭代,能够通过统一端到端模型来实现智能客服的快速、实时交互。第二是基于大模型的深度理解能力、情感元学习能力、海量知识储备与内容生成能力,可以实现“超拟人”的交互,通过客户实时情感识别来进行交流,解决传统智能客服“把天聊死”的问题。第三是通过外挂知识库,以及大模型快速知识学习、阅读长文本的能力,使得大模型在短时间内掌握海量知识,提高智能客服专业化水平,为用户提供专业化服务。第四是对于客户历史交互习惯的学习,来增强用户的个性化体验,真正做到千人千面的智能金融服务,甚至可以在用户没有提出问题前实现用户需求的主动预判。

在姚佶超看来,以当下技术发展迭代速度来看,在两到三年的时间中就有望实现金融服务的高度智能化发展。

对于未来人与AI的关系,姚佶超认为,从短期看是部分替代,长期看是辅助协同。

姚佶超指出,目前在客服场景下,大模型的应用已替代了一部分工作较为简单的人力,远程银行部门在服务量提升的情况下,客服坐席人数还在下降。“这对金融机构来说是实实在在的降本增效。”姚佶超表示,从长期来看,通用人工智能作为新质生产力,未来还是将以人机协同的形式,辅助人类完成工作流程中耗时多、价值低的部分环节,让人专注于专业性、创造性更强的环节。他提到,AI自身的能力很难达到行业专家的天花板水平,但可以为客户经理提供辅助,使得客户经理具备更高的专业度,从而为客户提供更优质的服务,提高服务水平。

展望未来,姚佶超认为大模型对金融行业在运营模式、风险管理、客户服务、产品创新等多个方面都将产生一系列深刻的变革。

特别是在OpenAI的o1模型发布后,相比过去的GPT模型,AI的逻辑推理能力得到显著提升,从而有望突破过去预训练模型在逻辑推理和数学计算方面的痛点问题,而讯飞星火预计今年底即将实现类OpenAIo1的高难度数学能力显著提升。

“在金融业最为关注的核心风控、交易等场景下,基于大模型对历史数据的学习与深度标签提取建模的能力,可以帮助机构分析潜在风险,并识别出优质客户群体,实现核心业务的辅助决策,提高资产管理水平。”姚佶超指出,在大模型的推理计算能力进一步提升后,还有望帮助金融机构实现市场的智能预测分析与智能决策评估,从而辅助、引导金融机构进行金融产品的开发与服务。

免责声明:该文章系本站转载,旨在为读者提供更多信息资讯。所涉内容不构成投资、消费建议,仅供读者参考。

向新而行|第21届青

向新而行|第21届青

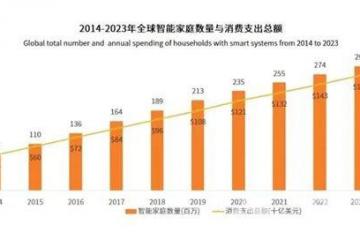

以“高质量”为引擎,智能家居产业怎

以“高质量”为引擎,智能家居产业怎 装智能家居没有零线怎

装智能家居没有零线怎

封阳台的看过来!别人家的大美阳台,

封阳台的看过来!别人家的大美阳台, 原来大多业主都在悄悄

原来大多业主都在悄悄

智能家居为什么从“伪需求”变成了“

智能家居为什么从“伪需求”变成了“ 智慧升级与绿色低碳同

智慧升级与绿色低碳同

Roca推出荣誉一体式智能座厕,升

Roca推出荣誉一体式智能座厕,升